El 29 de agosto del año pasado, en una conferencia que ofreció en Colombia, Carlos Coello Coello rememoraba la fecha, puesto que “conmemoraba” el día en que Skynet toma conciencia de sí y ataca a la humanidad. La referencia de la franquicia de ciencia ficción Terminator, fue utilizada por el computólogo para hablar sobre inteligencia artificial y LLM (Large Language Models), como los que utilizan diversos programas, como ChatGPT.

“Algunos piensan que ChatGPT es el corazón (o cerebro) de Skynet y eso nos llevará al fin de la humanidad. Esa es una visión pesimista, lo cierto es que la ciencia ficción opaca mucho los logros verdaderos de la IA y generan mucha confusión. Todavía hay cosas que la inteligencia artificial actual no puede hacer, aunque ha habido grandes avances”, dijo el académico durante la sesión inaugural del curso “Una breve introducción a la inteligencia artificial y sus aplicaciones”, realizado en El Colegio Nacional (ECN) y que se lleva a cabo esta semana de manera presencial y a través de su canal de YouTube.

#HOY continuará el #curso con Carlos A. Coello Coello en el AULA MAYOR sobre el futuro con #InteligenciaArtificial.

— El Colegio Nacional (@ColegioNal_mx) February 25, 2025

🔸 Del 24 al 28 de febrero · 18 h #entradalibre

🔸 Una breve introducción a la inteligencia artificial y sus aplicaciones

📍 Actividad presencial

🌐… pic.twitter.com/rVsG6mU1ES

“UNA LAPTOP Y 6 MDD”.

A lo largo de su exposición, hizo un paso breve sobre la historia de la computación vinculada con las redes neuronales y la inteligencia artificial a lo largo del siglo XX, aunque algunos conceptos se remontan hasta Aristóteles.

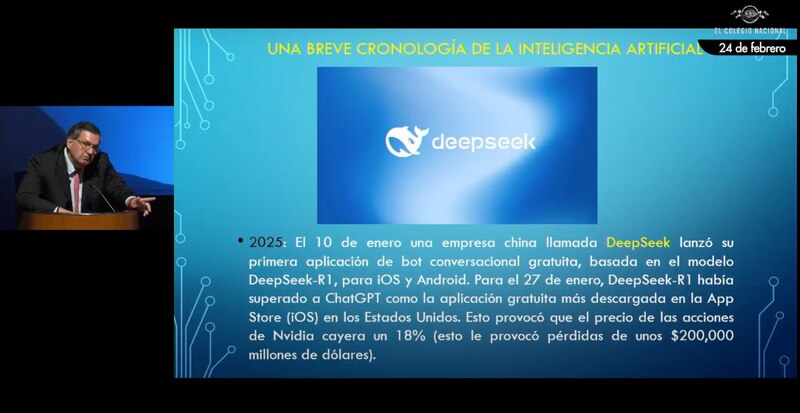

En este recorrido que llegó a la actualidad, expuso un tema que no tiene nada de ciencia ficción: el desarrollo tecnológico de China en este tipo de avances.

“En 2025, se dio a conocer una empresa china llamada DeepSeek que surgió de la nada y sacudió al mundo porque fue es un país al que está prohibido venderle tarjetas Nvidia” por veto del gobierno de Estados Unidos. “Antes de eso, el dueño de la empresa logró comprar 10 mil tarjetas, pero este programa ni siquiera fue entrenado con ese total, sino con muchas menos usando un esquema novedoso que costó ‘sólo’ 6 millones de dólares”, dijo el investigador emérito del Centro de Investigación y de Estudios Avanzados (Cinvestav) y miembro de ECN.

“Sólo” 6 mdd, acotó, teniendo en cuenta que –según la empresa Open IA– entrenar a ChatGPT costó más de mil millones de dólares. “Cuando Trump dice que EU meterá 500 mil millones de dólares a la infraestructura de IA vienen los chinos y dicen ‘miren, en mi laptop hice esta cosa y además es de código abierto –cosa que no ocurre con ChatGPT– y costó 6 mdd, unas cuantas tarjetas Nvidia –y otras tiradas por ahí que no servían las pusimos en la arquitectura–. Ahí está, pruébenlo, y nos dicen qué opinan’”, dijo bromeando el académico experto en computación evolutiva y Premio Crónica 2023.

Tras su lanzamiento, ha sido objeto de hackeos, récord de descargas y sigue siendo motivo de conversación sobre el futuro de esta tecnología, añadió Coello. “A quien más le dolió fue a Nvidia, que perdió 200 mil millones de dólares en un solo día, ya que bajó el precio de sus acciones: los encargados de las finanzas vieron que no es cierto que se requieren miles de millones de dólares para entrenar estas súper redes profundas”.

El miembro de El Colegio Nacional añadió que antes de DeepSeek, la mayoría del mundo pensó que no había forma de competirle a LLMs como ChatGPT y las otras empresas estadunidenses que han invertido miles de millones de dólares en sus propias IA.

En la Unión Europea, agregó, propició que se diera el anuncio de una inversión de 200 mil millones de euros para IA. “Los chinos demostraron que con un presupuesto de película mexicana se pueden hacer un LLMs”, bromeó Coello. “Abrieron esa ruta, porque China se quiere posicionar como líder en tecnología y llevan muchos años invirtiendo en ello”.

ELEFANTE EN LA HABITACIÓN.

Otro aspecto de los LLMs y los algoritmos de IA que parecen de ciencia ficción, pero no lo son es el costo medio ambiental que representa, enfatizó Carlos Coello Coello. Open IA, refirió, hizo un estudio que refiere que los procesos generan más dióxido de carbono (CO2) en el mundo son los LLMs. “Cada vez que hacen una consulta a ChatGPT, con un promedio de 20 o 40 preguntas, se consumen 500 mililitros de agua; el uso en un año equivale a 700 vuelos de Nueva York a San Francisco, por lo que este costo medioambiental es de una enorme preocupación –aunque no por Donald Trump”.

Este impacto es el que podría frenar los avances de esta tecnología, acotó, por lo que muchas empresas involucradas están pensando en, primero, cómo resolver este problema energético para después escalar su desarrollo. “No porque no se pueda hacer ahora, sino porque nos haríamos el harakiri; si seguimos al ritmo actual podríamos generar algoritmos maravillosos, formidables, pero que ya no habrá humanos que los vean. Siempre hay un lado negativo de la tecnología”.

Para ver la presentación completa de la sesión inaugural y el resto de las sesiones, sigue el canal de YouTube de El Colegio Nacional.